Wir alle kennen den Hype um ChatGPT und generative KI-Lösungen. Plötzlich scheint alles möglich zu sein, im Positiven wie im Negativen. KI spaltet, kreiert Erwartungen und schürt Ängste. Aber wie sieht die Zukunft der Fertigung wirklich aus? Was sind die realen Chancen und Risiken?

Koh Young kann die eingangs gestellten Fragen nicht zur Gänze beantworten, aber zeigen, wie KI-Anwendungen schon jetzt und in Zukunft die Elektronikfertigung nachhaltig verändern. Als ChatGPT vorgestellt wurde, schossen die Erwartungen in den Himmel, um sogleich wieder auf den harten Grund der Ernüchterung aufzuschlagen – spätestens als man bemerkt hatte, dass eine generative KI immer eine Antwort findet, egal ob diese wahr oder frei erfunden ist. Trotzdem hat ChatGPT bereits einzelne Berufsfelder und unser Leben nachhaltig verändert.

Künstliche Intelligenzen sind hoch spezialisierte Systeme, die mit ihrer Leistungsfähigkeit alles überflügeln. Aber wenn wir versuchen, unser Leben mit KIs wie z. B. ChatGPT zu regeln, stellen wir fest, dass wir kläglich scheitern. Warum? Weil diese Sprachmodelle darauf ausgelegt sind, möglichst lange mit uns zu interagieren. Das heißt, sie reden uns nach dem Mund. Gibt man der KI jedoch eine klare, eng umrissene Aufgabe, so liefert sie in Kürze herausragende Ergebnisse, z. B. die Gliederung für diesen Artikel.

In der Fertigung erleben wir genau dieses Szenario. Eine Vielzahl an unterschiedlichen KI-Lösungen unterstützt bei unterschiedlichen Fragestellungen und Aufgaben. Kompliziert wird es nur, wenn wir versuchen, die allwissende KI über die Produktion zu stülpen, die von der Metaebene bis in den kleinsten Prozessschritt alles regelt und kontrolliert. Das funktioniert nicht. Deshalb sind die KI-Lösungen unterteilt. Es gibt lokale Lösungen auf Prozessebene und übergeordnete Lösungen, die auf die Ergebnisse zugreifen. Darüber gibt es noch die Metaebene, die diese Daten mit weiteren Faktoren, wie z. B. Materialbeschaffung, Energieverbrauch, Bestellverhalten der Kunden etc., verknüpft. Im Klartext heißt dies, dass KI-Lösungen nicht miteinander konkurrieren. Sie ergänzen sich und bauen aufeinander auf.

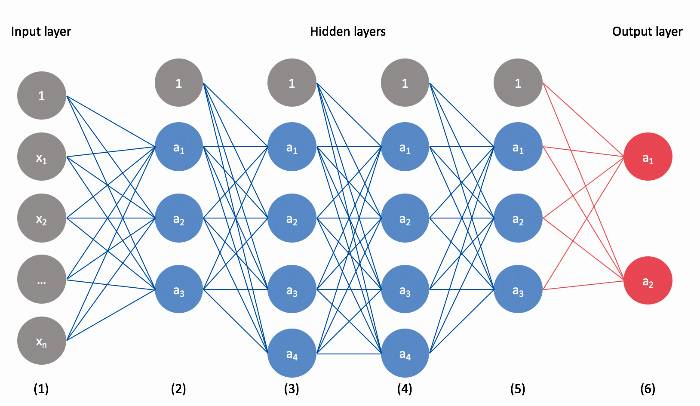

Der Begriff der ‚artificial intelligence' (AI) wurde in den 1950er-Jahren des letzten Jahrhunderts formuliert. Die Idee war, menschliches Verhalten und Entscheidungen künstlich zu reproduzieren. Die Blaupause hierfür lieferten die Neuronen auf der Großhirnrinde des menschlichen Gehirns. Ein Neuron ist im Durchschnitt mit 5.000 Nachbarneuronen verbunden. Eingehende Nervenimpulse werden von diesem Netzwerk in Sekundenbruchteilen aufbereitet und gefiltert, sodass bei einem plötzlich auf uns zufliegenden Balls nicht alle Gliedmaßen zucken, sondern nur die Arme und Hände zum Fangen des Balls nach oben schnellen. Diese neuronalen Netzwerke bilden die Basis aller KI-Lösungen. Man unterscheidet lediglich nach Tiefe (Anzahl der Lagen) und dem Aufbau der Netzwerke.

Jedem Tierchen sein Pläsierchen: KI-Modelle und ihre Anwendungsgebiete in der optischen Inspektion

Einfache Systeme benötigen nur eine einfache Lösung. Grammatik und Rechtschreibung unterliegen klaren eindeutigen Regeln. Deshalb kommen bei der Rechtschreibkorrektur die einfachsten neuronalen Netzwerke zum Einsatz, die CNNs [convolutional neural network] (Abb. 1). Dabei handelt es sich um Feed-Forward-Netzwerke. Der Input-Layer gibt die Daten an die Hidden-Layer weiter. Jeder Layer fungiert wie ein Sieb, das nur bestimmte Daten oder Datenkombinationen durchlässt. Zum Beispiel Groß-/Kleinschreibung. Die Eingangsgröße wäre eine Zeichenkette und die Filterbedingungen könnten lauten: Punkt, Doppelpunkt, Ausrufezeichen oder Fragezeichen. Die nächste Abfrage könnte prüfen, ob ein Leerzeichen vorhanden und der nächste Buchstabe großgeschrieben ist.

Statt einer Zeichenkette könnte es aber auch eine Zeile aus Pixel-Informationen sein, die von einer Inspektionskamera aufgenommen wurden, und wir prüfen, ob der Grauwert Lötstopplack, Kupfer-Pad oder Lötpaste repräsentiert. In der optischen Inspektion werden diese Netzwerke zum Aufbereiten der Rohdaten und zur Datenanalyse genutzt. Die KSMART Server Applikationen von Koh Young nutzen CNNs zur Datenaufbereitung (Data Operations) für die Prozessanalyse und zur Bereitstellung der Daten für KI-Anwendungen zur Prozesskontrolle und -steuerung.

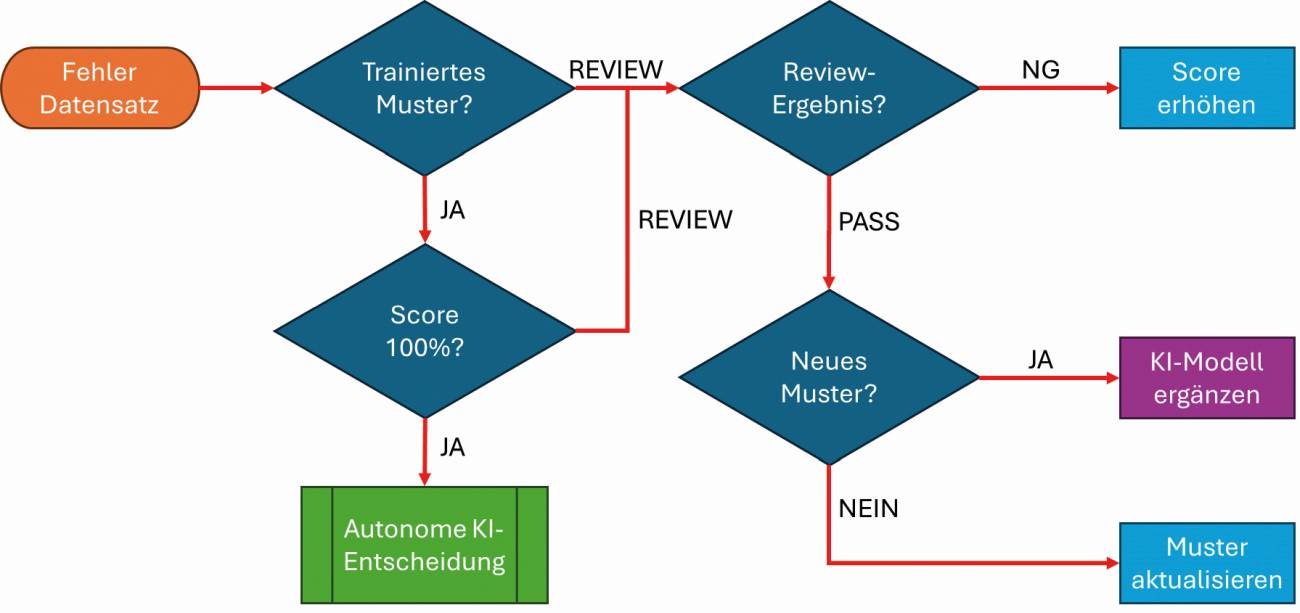

CNNs müssen programmiert werden. D. h., anhand vieler Datenbeispiele entwickelt der Programmierer sein Netzwerk. Stellt man einen Schlupf oder Fehler fest, wird nachgebessert. Will man diesen Aufwand vermeiden, benutzt man maschinelles Lernen (ML). Beim maschinellen Lernen wird ein vordefiniertes Netzwerk verwendet. Fehlende Verknüpfungen werden anhand menschlicher Expertenentscheidungen erlernt (überwachtes Lernen [Supervised Learning]). Auf die SMT-Welt bezogen können wir den AOI-Review-Platz heranziehen. Das AOI sortiert fehlerhafte Leiterplatten aus. Die Person am Review-Platz verifiziert den Fehler oder überstimmt das AOI-Ergebnis, sie klassifiziert also die Eingabedaten für das KI-Modell. Im PASS-Fall wird eine neue Verknüpfung im neuronalen Netzwerk geschaffen und bei der nächsten AOI-Prüfung angewendet. Im Fall einer Bestätigung des AOI-Ergebnisses erhöht sich die Zuverlässigkeit des KI-Modells. D. h., bei ausreichender Sicherheit wird der Fehler gar nicht mehr am Review-Platz angezeigt. Das Ergebnis: Nach einer ausreichenden Trainingszeit entscheidet die KI autonom (Abb. 2).

Abb. 2: Trainingsprozess Maschinelles Lernen am AOI-Review-Platz

Abb. 2: Trainingsprozess Maschinelles Lernen am AOI-Review-Platz

Die Achillesferse des maschinellen Lernens ist der menschliche Entscheider/Trainer. Ist seine Einschätzung falsch, wird das KI-Modell fehlerhaft programmiert. Deshalb arbeitet das ‚Smart Review' von Koh Young mit der beschriebenen Zuverlässigkeit des Fehlers (siehe Abb. 2). Es ist eine Absicherung, damit Fehlentscheidungen das KI-Modell nicht gefährden. Erst wenn eine Neuverknüpfung zu 100 % verifiziert wurde, übernimmt das KI-Modell die neue Verknüpfung in die autonome Bewertung.

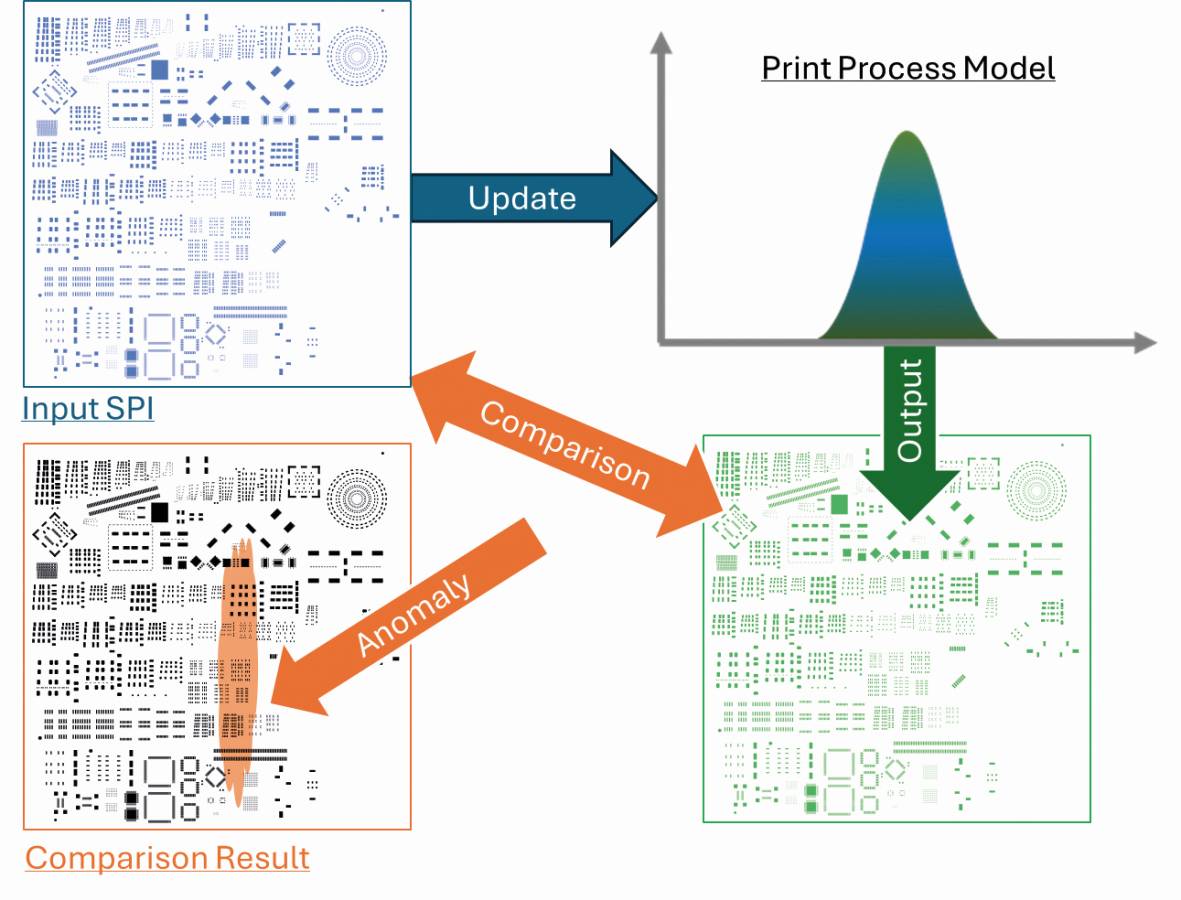

Beim überwachten Lernen soll eine definierte Zielvariable erreicht werden. In unserem AOI-Beispiel ein Fehler, der sicher detektiert werden soll. Beim unüberwachten Lernen [Unsupervised Learning] sollen aus einer Datenmenge, die einen Prozess darstellt, Gruppen und Segmente erzeugt und versteckte Muster entdeckt werden. Hierzu bedarf es keines menschlichen Experten. Die Algorithmen analysieren selbstständig die Daten und erkennen Muster und Zusammenhänge. Ein Beispiel hierfür ist der SMT-Druckprozess. Der menschliche Druckexperte schaut auf das Druckbild und erkennt anhand der Volumenstreuung Störeffekte wie z. B. beschädigte Leiterplattenklemmen oder Rakelblätter. Ein KI-Modell des Druckprozesses kann mithilfe dieser aufbereiteten Daten zu den gleichen Ergebnissen kommen wie ein erfahrener Prozessexperte. Deshalb nutzt Koh Young diese Form der KI zur Diagnose des Druckprozesses bei der Real-Time-Prozesskontrolle des SMT-Drucks. Dabei übernimmt die KI die volle Parameterkontrolle der Druckmaschine (Koh Young Process Optimizer Printer - KPO P).

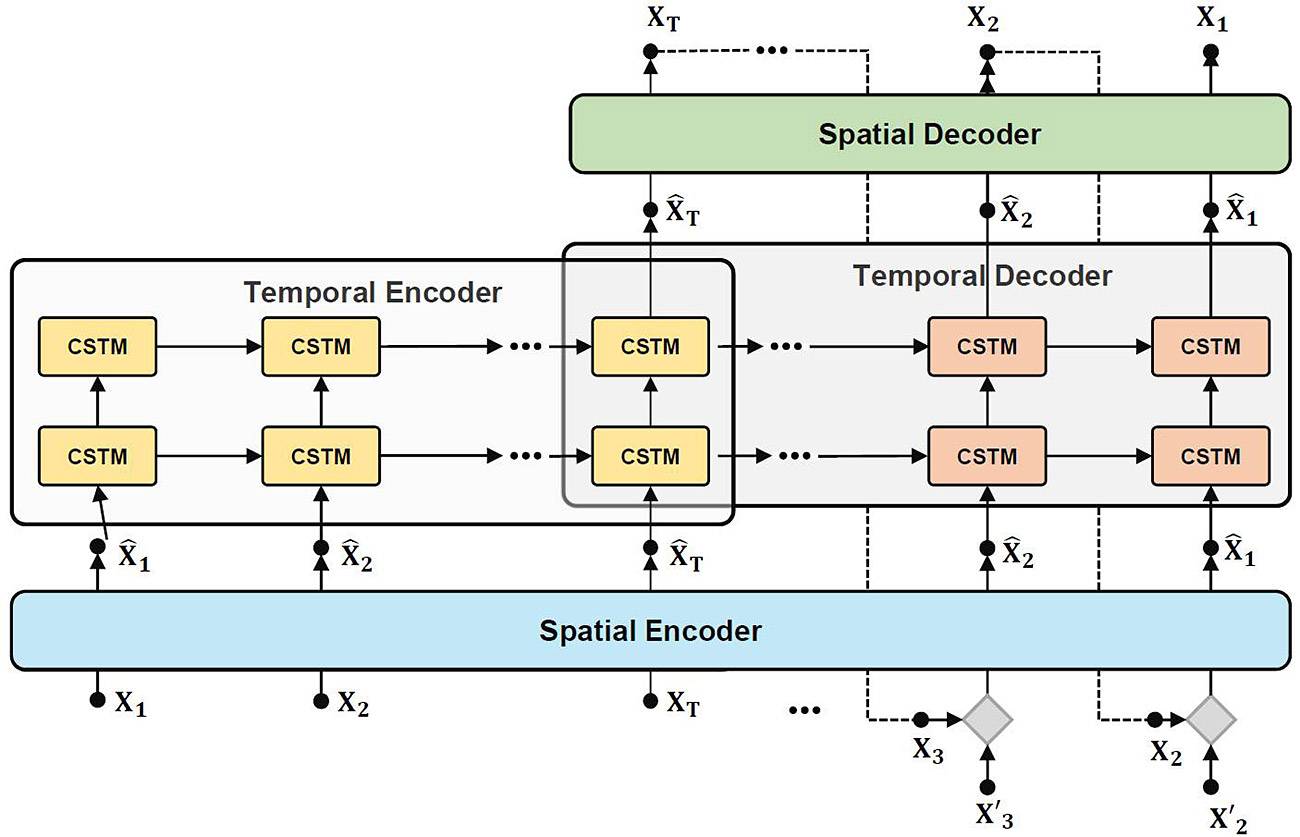

Um Prozesse effektiv zu steuern, sollte der Regelkreis nicht auf Einmaleffekte und Anomalien reagieren. Hierzu müssen die Effekte eindeutig klassifiziert werden. Denn ein defektes Rakelblatt kann nicht durch den Regelkreis kompensiert werden. Hier hilft nur ein Hinweis an das Linienpersonal durch die Druckdiagnose. Abbildung 3 zeigt ein solches Netzwerk.Bei diesem Netzwerk (RNN = Recurring Neural Network) werden die Daten jedes Drucks klassifiziert und dem Prozessmodell hinzugefügt. Die klassifizierten Daten werden dann noch einmal mit dem Modell verglichen. Dadurch werden ungewöhnliche Abweichungen und Muster sichtbar und als Prozessanomalien gekennzeichnet.

Abb. 3: Recurrent Neural Network (RNN) – Der Spatial Encoder setzt die mehrdimensionalen Prozessdaten in Zeileninformationen um. Der Temporale Encoder komprimiert die Eingangsdaten und entfernt dabei die Störgrößen/ Fehler. Der Temporale Decoder dekomprimiert die Daten wieder und rekonstruiert den laufenden Prozess ohne Störgrößen. Der Spatial Decoder wandelt die rekonstruierten Prozessdaten wieder in Zeileninformationen. Der Vergleich von Spatial Encoder und Decoder zeigt nun die Anomalien und Fehler in den Eingangsdaten und die Druckprozess-KI kann die Anomaliemuster Prozessfehlern, wie z. B. einem defekten Rakelblatt zuordnen (siehe auch Abb. 4)

Abb. 3: Recurrent Neural Network (RNN) – Der Spatial Encoder setzt die mehrdimensionalen Prozessdaten in Zeileninformationen um. Der Temporale Encoder komprimiert die Eingangsdaten und entfernt dabei die Störgrößen/ Fehler. Der Temporale Decoder dekomprimiert die Daten wieder und rekonstruiert den laufenden Prozess ohne Störgrößen. Der Spatial Decoder wandelt die rekonstruierten Prozessdaten wieder in Zeileninformationen. Der Vergleich von Spatial Encoder und Decoder zeigt nun die Anomalien und Fehler in den Eingangsdaten und die Druckprozess-KI kann die Anomaliemuster Prozessfehlern, wie z. B. einem defekten Rakelblatt zuordnen (siehe auch Abb. 4)

Abb. 4: Aktualisierung des Prozessmodells durch die aktuelle Messung mit anschließendem Vergleich des Prozessmodells zu den Eingangsdaten. Die Größe der einzelnen Abweichung (auf das Pad bezogen) entscheidet über die Einstufung als Anomalie. Anzahl und Positionen der Anomalien lassen auf die Ursache schließen

Abb. 4: Aktualisierung des Prozessmodells durch die aktuelle Messung mit anschließendem Vergleich des Prozessmodells zu den Eingangsdaten. Die Größe der einzelnen Abweichung (auf das Pad bezogen) entscheidet über die Einstufung als Anomalie. Anzahl und Positionen der Anomalien lassen auf die Ursache schließen

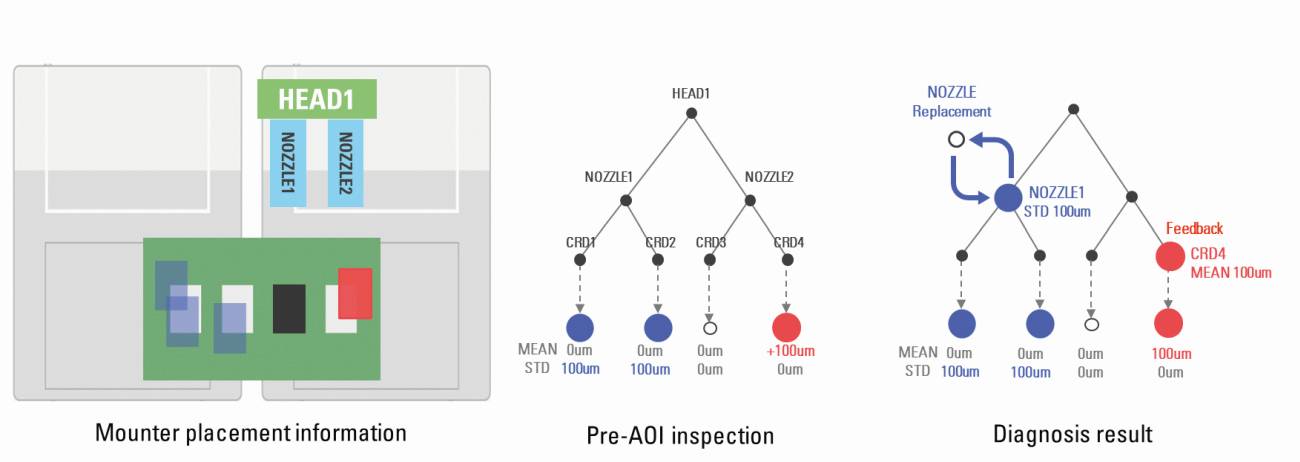

Ähnliche KI-Technologien werden bei der Diagnose des Bestückprozesses eingesetzt. Bei KPO-M (Koh Young Process Optimizer Mounter) muss zwischen einem echten Offset des Bauteils und einer Prozessstörung durch defekte Bestückwerkzeuge (Nozzels), Feeder oder Reels unterschieden werden. Defekte Komponenten im Bestückprozess verursachen eine höhere Streuung in der Bestückungposition. Diese lässt sich über eine Korrektur der Bestückposition nicht kompensieren. Hier muss wieder eine Anweisung an das Linienpersonal erzeugt werden, damit die entsprechenden Komponenten geprüft oder ausgetauscht werden. Einen echten Offset erkennt man dagegen an der Mittelwertverschiebung zur Bestückposition. Diese lässt sich leicht durch einen Korrekturbefehl an den Bestücker beseitigen. Abbildung 5 zeigt das Prinzip der KPO Mounter Analyse.

Abb. 5: Wirkweise der KPO Mounter Real-Time-Kontrolle

Abb. 5: Wirkweise der KPO Mounter Real-Time-Kontrolle

Die Effizienz der KI-Modelle steht und fällt mit der Qualität der Daten. Das vorherrschende Messprinzip für die 3D-Messung hat sich in den letzten 20 Jahren nicht verändert. Das Moiré-Phase-Shift-Verfahren ist weiterhin die erste Wahl für die industrielle 3D-Messung. Das Warum diskutieren wir in einem anderen Artikel in der Novemberausgabe der PLUS.

Über die Jahre gab es verschiedene Innovationen des Messverfahrens. Koh Young hat in diesem Zusammenhang die meisten Patente angemeldet. Die Innovationen auf der Hardware-Seite sind überschaubar. Neben dem Multi-Frequency-Verfahren hat sich die DLP-Technologie etabliert. Die Unterschiede und Vor- und Nachteile werden wir ebenfalls in der Novemberausgabe diskutieren. Alle anderen Hardware-Innovationen basieren auf der Weiterentwicklung der Kamera- und PC-Technologie. Die verborgenen Innovationen klingen fast schon wieder nach einem Widerspruch. Die Zuverlässigkeit der Daten für die KI-Anwendung wird durch KI gewährleistet.

Was bedeutet das? Seit vielen Jahren optimieren Entwickler die Aufbereitung der Rohdaten einer Messung mit KI. Denn die Rohdaten sind erst einmal eine Ansammlung von Pixel-Grauwerten. Zu jedem Pixel gibt es pro Messung zwischen 11 bis 42 Werte. Das hängt davon ab, ob es sich um ein SPI oder AOI handelt und wie der Messkopf aufgebaut ist. Bei einer 12 Mpx-Kamera sprechen wir also von 132 bis 504 Mio. Werten pro Kamerafeld und Messung. Bei einer normal bestückten Baugruppe von 360 × 200 [mm] wären das ca. 28 Kamerafelder und entsprechend 3,696 bis 14,112 Mrd. Werte. Spätestens jetzt müsste jedem klar sein, welche Rechen-Power in der optischen Inspektion steckt.

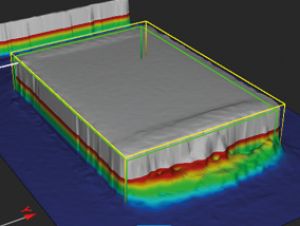

Umso beeindruckender, dass diese Datenverarbeitung im Takt der In-Line-Produktion stattfindet. Die KI klassifiziert an dieser Stelle die Daten. D. h., Messrauschen in Form von Messspitzen oder fehlenden Werten werden nicht mehr durch Rendering (Mittelwertbildung) geglättet, sondern entfernt und rekonstruiert. Was ist der Unterschied? Abbildung 6 zeigt die klassische Rekonstruktion von 3D-Daten einer Lötstelle mittels Rendering. Der Fachmann erkennt sofort, dass eine solche Lötstelle nicht realistisch ist. Physikalisch würde sich das flüssige Lot beim Benetzen und Erstarren anders verhalten.

Natürlich gibt es kosmetische Verfahren, die dieses Bild noch einmal aufhübschen können, aber das wird nicht den Wahrheitsgehalt des 3D-Modells erhöhen. In Abbildung 7 sehen wir die gleiche Lötstelle mit einer KI-Rekonstruktion. Im Gegensatz zum Rendering filtern die KI-Algorithmen Spikes und Löcher aus den Rohdaten aus. Die fehlenden Daten werden mit der Hilfe von GAN (Generative Adversarial Networks) aufgearbeitet, sodass die Datenlücken mit realistischen Werten aufgefüllt werden.

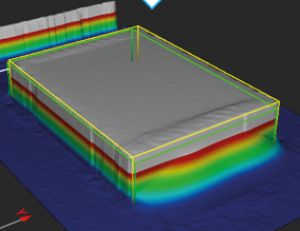

Das gleiche Verfahren wird auch zur Fehlersimulation verwendet. Die Effektivität von KI-Modellen erhöht sich mit der Anzahl der Trainingsdaten. Allerdings erzielt eine durchschnittliche Produktion ein First Pass Yield (FPY) besser 94 %. Das sind zu wenig Fehler, um eine schnelle effektive Modellierung des Prozessgeschehens zu erreichen. Die GAN-Technologie schafft hier Abhilfe. In kürzester Zeit werden Tausende Fehlersimulationen erzeugt, die die KI-Modelle robust und leistungsfähig machen.

Wie funktioniert das? Die Wirkweise von GAN erinnert mich immer an das Lexikon-Spiel, welches Sie vielleicht kennen. Jemand nennt einen Begriff aus dem Lexikon und alle Spieler überlegen sich realistische Lexikon-Erklärungen zu diesem Begriff, mit dem Ziel, alle hinters Licht zu führen. GAN arbeitet nach dem gleichen Prinzip!

In Abbildung 8 sehen wir die schematische Darstellung einer GAN KI. Sie startet mit realen Daten eines Fehlerbilds. Basierend auf diesen Daten, erzeugt ein Bildgenerator (Generator) ‚Fake'-Fehlerbilder. Der Diskriminator vergleicht nun reale und Fakedaten. Wenn der Diskriminator überlistet wird, haben wir eine realistische Fehlersimulation und diese wird gespeichert. Sagt der Diskriminator ‚Fake', wird das Fehlermodell verworfen. Das Ergebnis sind sehr zuverlässige Simulationen, die die Fehlerdetektion stabilisieren und optimieren.

Smart Factory

Wir haben nun gelernt, wo und welche KI-Modelle in der optischen Inspektion der SMT-Fertigung vorkommen. Was hat das nun mit der Smart Factory der Zukunft zu tun? Nehmen wir mal ein einfaches Beispiel. Mir ist bewusst, dass der Thermomix die Gesellschaft spaltet, aber was ist sein großer Vorteil? Ich werfe alle Zutaten hinein, drücke Start und sauge in der Zwischenzeit das Wohnzimmer. Das heißt: Er kocht autonom. Wir wollen das Gleiche in der SMT. Der Bediener drückt Start und die Inspektion läuft autonom – ohne Bedienereingriff! Das funktioniert nur, wenn die Messergebnisse absolut vertrauenswürdig sind und die Beurteilung durch eine KI besser als der Bediener agiert. Deshalb all der Aufwand. Kein Prozesstechniker dieser Welt kann in Real-Time die Millionen Daten der Messsysteme beherrschen. Wir sind also, wie beim Autofahren, auf Assistenzsysteme angewiesen.

KI ist an dieser Stelle unser Multi-Tool. Keine andere Technologie kann so schnell und effektiv die großen Datenmengen, die im 20-s-Takt für jede Baugruppe erzeugt werden, handhaben. Darüber hinaus sind diese Daten die Grundlage für die Abbildung der Produktionsprozesse Drucken, Bestücken und Löten. Die Nutzung eines digitalen Twins des Produktes wird ohne diese Daten nicht möglich sein. Tauchen wir tiefer in das Thema Smart Factory ein, so erreichen wir schnell die Archillesferse des Konzepts. Eine globale Smart-Factory-KI kann die Datenflut der einzelnen Linien nicht in Echtzeit bewältigen. Zum einen ist die Datenübertragung ein Flaschenhals und zum anderen würde die Rechnerleistung knapp. Deshalb müssen auf den Linien Edge-KIs verwendet werden, die nur Ergebnisse weitergeben.

Dieses Konzept bildet Koh Young mit der KSMART Server- und KPO-Infrastruktur ab. Die linienbezogenen Daten bleiben auf dem KSMART Server, der diese mittels APIs (Application Programmable Interfaces) an andere Applikationen oder übergeordnete KIs weitergeben kann. Solche Applikationen können lokale KIs sein, die aufgrund von Echtzeitaspekten (Real-Time) nah am Prozess arbeiten. Ein Beispiel ist die KPO-Printer-KI, die – in das SPI integriert – die komplette Prozesskontrolle des Lotpastendrucks übernimmt. Diese KIs teilen ebenfalls ihre Informationen und Optimierungsergebnisse über den KSMART Server, der somit zum Prozessdaten-Broker für die Fertigungs-KI wird.

Die Idee der Smart Factory

Bild: Google Gemini, Prompt: Axel LindloffWenn wir Gemini, die KI von Google, nach der Definition der Smart Factory fragen, bekommen wir folgendes Ergebnis (Abb. 9).

Bild: Google Gemini, Prompt: Axel LindloffWenn wir Gemini, die KI von Google, nach der Definition der Smart Factory fragen, bekommen wir folgendes Ergebnis (Abb. 9).

Eine bessere Definition wäre mir wahrscheinlich auch nicht eingefallen. Wenn man dies liest, versteht man sofort das ‚Warum', das die Hersteller von Inspektionssystemen bei der KI-Integration antreibt. Wir sind heute schon nah an der vollständigen Autonomie von Inspektionssystemen. Allerdings benötigen einige Schritte immer noch das manuelle Eingreifen an der Produktionslinie.

Ist das kritisch? Nein, denn die Lücken in den Abläufen werden schnell geschlossen. Psychologisch ist es sogar von Vorteil. Wenn das Inspektionsgerät von heute auf morgen plötzlich zur Blackbox wird und autonom entscheidet, gibt es mit hoher Wahrscheinlichkeit ein Vertrauensproblem in den Produktionen. So aber können alle Beteiligten erst einmal Erfahrungen sammeln, bevor in der smarten Fertigung eines Tages das Licht ausgeht.

Zur Person

Zur Person

Axel Lindloff; ist Dipl.-Ing. (FH) der Elektrotechnik und arbeitet seit 2012 für Koh Young Europe. Als Senior Process Specialist ist er für alle Fragen rund um den SMT-Process und die Datenanalyse verantwortlich. Hierbei baut er auf 25 Jahre Erfahrung als Trainer und Applikationsingenieur. Gemeinsam mit dem Team von Koh Young Europe freut er sich darauf, Interessenten und Partner auf der productronica in Halle A2, Stand 377, zu begrüßen.