Mit Inkrafttreten des Artificial Intelligence Acts (AIA) der EU am 1. August 2024 begann eine neue Ära der Regulierung von künstlicher Intelligenz in Europa. Dabei stehen verbotene KI-Systeme und Hoch-Risiko KI-Systeme (HR-KI) im Fokus. In diesem Beitrag, der auf einer aufschlussreichen Zusammenfassung des VDE basiert, erfahren Sie, welche Anforderungen seit 2025 auf Anbieter und Betreiber zukommen.

Schrittweise Einführung definiert den Fahrplan

Die verschiedenen Teile des AIA werden nach und nach eingeführt:

- So sind z. B. die allgemeinen Bestimmungen schon seit dem 2. Februar 2025 gültig und verbotene Praktiken definiert

- Seit dem 2. August 2025 gelten u. a. die Bestimmungen für Hochrisiko-Systeme (HR), für Governance und die Art der Sanktionen

- Die meisten weiteren Bestimmungen ab 2. August 2026

- Einstufungsregeln für KI-Systeme mit hohem Risiko ab 2. August 2027

Was ist ein KI-System?

Sinngemäß definiert der AIA ein KI-System als ein maschinengestütztes System, das so konzipiert ist, dass es mit unterschiedlichem Grad an Autonomie betrieben werden kann und Anpassungsfähigkeit zeigt und das für explizite oder implizite Ziele aus den Eingaben, die es erhält, ableitet, wie es Ausgaben (Vorhersagen, Inhalte, Empfehlungen oder Entscheidungen) generieren kann, welche die physische oder virtuelle Umgebung beeinflussen können.

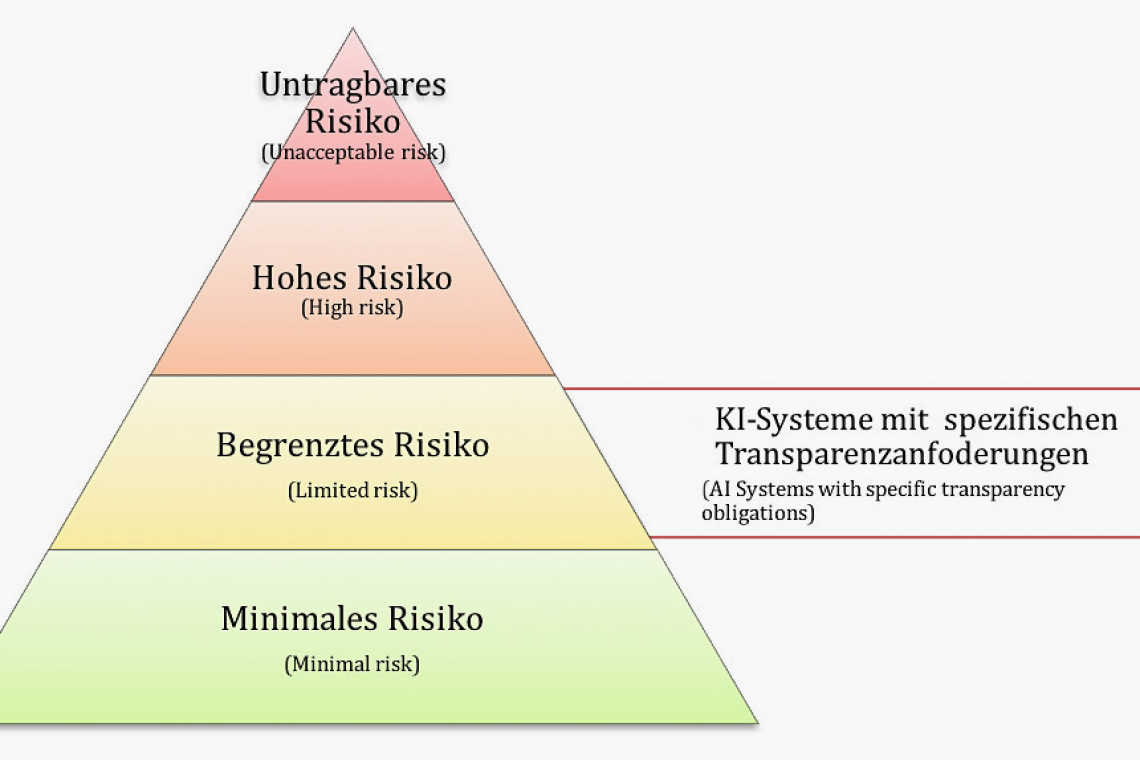

Klassifikation nach Risiko

KI-Systeme werden folgendermaßen eingeteilt:

- Nicht-akzeptables Risiko in Bezug auf acht verbotene Praktiken, welche im AIA Art. 5 erläutert werden

- Hohes Risiko gemäß Art. 6 AIA, diese KI-Systeme unterliegen Konformitätsbewertungsverfahren durch Dritte wie bei Medizinprodukten

- Begrenztes Risiko mit speziellen Auflagen zur Transparenz (Art. 50 AIA), z. B. Chatbots

- Minimales oder kein Risiko, für die Anbieter freiwillige Verhaltenskodizes (Art. 95 AIA) einhalten sollen, z. B. Videospiele oder Spamfilter

Sonderfall KI-Systeme mit allgemeinem Verwendungszweck

Bei so einem System handelt es sich um „ein KI-System, das auf einem KI-Modell mit allgemeinem Verwendungszweck beruht und in der Lage ist, einer Vielzahl von Zwecken sowohl für die direkte Verwendung als auch für die Integration in andere KI-Systeme zu dienen“.

Kapitel 5 des AIA benennt die allgemeinen Verpflichtungen der Anbieter solcher KI, z. B. das Erstellen einer technischen Dokumentation oder die Bereitstellung von Informationen für andere Anbieter.

Sichere Entwicklung und Anwendung von Hoch-Risiko-KI-Systemen

Seit dem 2. Februar 2025 sind Anbieter und Betreiber von HR-KI zum Aufbau von ausreichender KI-Kompetenz verpflichtet. So sollten Betreiber sicherstellen, dass die Personen, denen die Umsetzung der Betriebsanleitungen und die Aufsicht übertragen wurde, über ein angemessenes Niveau an KI-Kompetenz verfügen, Wissen und Befugnis haben, um diese Aufgaben auch zu erfüllen.

Seit dem 2. Februar 2025 sind Anbieter und Betreiber von HR-KI zum Aufbau von ausreichender KI-Kompetenz verpflichtet. So sollten Betreiber sicherstellen, dass die Personen, denen die Umsetzung der Betriebsanleitungen und die Aufsicht übertragen wurde, über ein angemessenes Niveau an KI-Kompetenz verfügen, Wissen und Befugnis haben, um diese Aufgaben auch zu erfüllen.

Was müssen Anbieter von Hoch-Risiko-KI-Systemen jetzt tun?

Als Basis für die Sicherheit und Leistungsfähigkeit von HR-KI müssen ein Risikomanagement- und ein Qualitätsmanagementsystem etabliert, fortlaufend weiterentwickelt und aufrechterhalten werden, wobei für KMU und Start-ups eine vereinfachte Bereitstellung der technischen Dokumentation vorgesehen ist.

Anbieter müssen z. B.die Rückverfolgbarkeit der Systemfunktionen (Prozesse und Ereignisse) und die Überwachung nach dem Inverkehrbringen gewährleisten, u. a. durch eine automatische Aufzeichnung von Ereignissen während des Lebenszyklus.

Weiterhin sieht der Gesetzgeber umfangreiche Transparenzpflichten und Aufbewahrungsfristen vor. Für KI-Systeme, die für die direkte Interaktion mit natürlichen Personen bestimmt sind, wird beispielsweise gefordert, dass die Personen informiert werden, dass sie mit einem KI-System interagieren. Eine Liste der Anforderungen ist auf der Homepage des VDE zu finden.

Konformitätsbewertung

Je nach Anwendungsfall ist auch eine Konformitätsbewertung der HR-KI vorzunehmen.

HR-KI-Anbieter stellen eine schriftliche maschinenlesbare, physische oder elektronisch unterzeichnete EU-Konformitätserklärung aus, „die sich auf alle für das Hochrisiko-KI-System geltenden Rechtsvorschriften der Union bezieht“.

Welche Aufgaben haben Betreiber von Hoch-Risiko-KI-Systemen?

Die Pflichten für Betreiber von HR-KI fasst der Art. 26 AIA zusammen. So müssen diese u. a. geeignete Maßnahmen ergreifen, um sicherzustellen, dass sie solche Systeme entsprechend den beigefügten Betriebsanleitungen verwenden. Auch müssen, basierend auf der technischen Implementierung durch den Anbieter, die Vorgaben zur menschlichen Aufsicht umgesetzt werden. Betreiber haben Meldepflichten hinsichtlich schwerwiegender Vorfälle gegenüber Anbietern, Einführern, Händlern und Marktüberwachungsbehörden. Weitere Anforderungen beziehen sich u. a. auf die Unterrichtung von Arbeitnehmervertretern und betroffenen Arbeitnehmern über die Verwendung der HR-KI und die Pflicht zur Durchführung einer Datenschutz-Folgenabschätzung.

Für dazulernende KI-Systeme gilt, dass im Falle einer wesentlichen Änderung die HR-KI einem neuen Konformitätsbewertungsverfahren unterzogen wird, und zwar unabhängig davon, ob das geänderte System noch weiter in Verkehr gebracht oder vom derzeitigen Betreiber weitergenutzt werden soll.

Vorbereitung auf den AIA durch Anbieter und Betreiber

Die Einrichtung von KI-Reallaboren soll es Anbietern ermöglichen, KI-Systeme für einen bestimmten Zeitraum zu entwickeln, zu trainieren, zu testen und zu validieren, bevor sie auf den Markt gebracht werden. Darüber hinaus können die Anbieter unter bestimmten Bedingungen ihre Systeme unter realen Bedingungen außerhalb der KI-Reallabore testen.

Fest steht, dass Anbieter und Betreiber von KI-Systemen frühzeitig bei ihrem Personal entsprechende Kompetenzen aufbauen müssen. Anbieter von HR-KI sollten den erhöhten Aufwand in der technischen Dokumentation und dem Qualitätsmanagement in Bezug auf organisatorische und finanzielle Ressourcen jetzt schon berücksichtigen.

www.vde.com/topics-de/kuenstliche-intelligenz/news/ki-systeme-eu-artificial-intelligence-act, https://eur-lex.europa.eu/eli/reg/2024/1689/oj